Quelles limites à l’intégration d’ENR variables et intermittentes, d’origine éolienne et photovoltaïque, dans les réseaux électriques ? Quelles conséquences ?

Une tribune de Georges Sapy – Mai 2024

Résumé de l’essentiel

Depuis l’invention par Nikola Tesla en 1891 de l’alternateur triphasé, les réseaux en courant alternatif se sont répandus dans le monde entier. Jusqu’à la fin du siècle dernier, les alternateurs, entraînés par des turbines (hydrauliques, à vapeur ou à gaz) ou par des groupes diesel, ont eu le monopole de l’alimentation de ces réseaux. Ils ont la propriété essentielle, une fois couplés à un réseau, de fonctionner ensemble de façon parfaitement synchrone, définissant ainsi à tout instant la fréquence commune f du réseau. Ils apportent en outre l’inertie mécanique de leurs rotors au réseau, cette inertie étant indispensable pour stabiliser la fréquence et amortir ses variations.

Cependant, à l’orée des années 2000, le souci de plus en plus prégnant du réchauffement climatique a conduit à utiliser les énergies du vent, via des éoliennes, et du soleil, sous forme photovoltaïque essentiellement, d’une part parce qu’elles permettaient de produire de l’électricité sans émettre de CO2 lors de leur fonctionnement, d’autre part parce qu’elles présentaient un potentiel de croissance jugé très important. Cependant, l’intégration croissante de ces sources d’électricité, par nature variables et intermittentes, impacte profondément le fonctionnement des réseaux pour deux raisons :

* Une raison liée à leur variabilité : cette dernière, rarement corrélée aux besoins, se cumule en effet à celle de la consommation, conduisant à une variabilité globale très supérieure à celle de la seule consommation dès que leur taux d’intégration dans les réseaux devient notable. Cela implique, afin de maintenir à tout instant l’indispensable équilibre entre production et consommation, de mettre en œuvre des moyens d’équilibrage dont les plus importants sont les moyens de stockage-déstockage d’énergie et surtout la modulation de puissance des productions pilotables. Cela constitue une première cause de limitation de l’intégration d’électricité variable et intermittente, pour des raisons : d’échelle physique des moyens palliatifs à mettre en œuvre ; de faisabilité des moyens de stockage-déstockage d’énergie à grande échelle, STEPs (stations de transfert d'énergie par pompage) par exemple ; et finalement de coûts d’investissement.

* Une raison technique : ces sources d’électricité ne sont plus couplées au réseau de manière synchrone comme les alternateurs, mais via des onduleurs électroniques de puissance. C’est une nécessité pour les panneaux photovoltaïques qui produisent naturellement du courant continu qu’il faut transformer en courant alternatif à 50 Hz grâce à des onduleurs pour l’injecter dans le réseau. C’est un choix pour les éoliennes modernes de grande puissance : afin de capter de façon optimale la puissance variable du vent, elles doivent fonctionner à vitesse variable. L’alternateur qu’elles entraînent ne délivre donc pas un courant à 50 Hz, qui de ce fait ne peut être directement injecté dans le réseau. On utilise alors une chaîne électronique complexe qui consiste à convertir le courant alternatif à fréquence variable produit par l’alternateur en courant continu grâce à un redresseur puis à le retransformer en courant alternatif à 50 Hz grâce à un onduleur couplé au réseau.

L’interface avec le réseau se fait donc dans les deux cas par des moyens électroniques (onduleurs de puissance) qui ont des propriétés très différentes de celles des alternateurs : ils ne permettent pas à ce jour de « former » le réseau en fréquence f et en tension U (ils ont besoin d’un réseau déjà formé pour injecter leur puissance) et ils n’ont évidemment aucune inertie mécanique à apporter au réseau.

Il est alors facile de comprendre que lorsque l’on remplace progressivement les productions pilotables couplées au réseau via des alternateurs, par des productions éoliennes et/ou photovoltaïques couplées via des onduleurs électroniques, on affaiblit la capacité des réseaux à former leur fréquence f et leur tension U ainsi que leur indispensable inertie, car il arrive un moment où le nombre d’alternateurs n’est plus suffisant pour assurer ces deux fonctions vitales de façon sûre. C’est la deuxième cause de la limitation du taux d’intégration possible d’électricité variable et intermittente.

Où en est-on actuellement des connaissances concernant les limites d’intégration d’électricité variable et intermittente dans les réseaux ? On peut se référer à deux sources très sérieuses :

* La première source est l’étude publiée en juin 2015 par EDF R&D [1]. Elle porte sur l’ensemble du réseau européen à l’horizon 2030 et est basée sur environ 30 ans d’historiques météorologiques et de consommations. Elle conclut, moyennant quelques conditions complémentaires de second ordre, qu’il est possible d’atteindre un taux d’intégration d’électricité variable et intermittente d’environ 40 % en valeur moyenne annuelle, ce taux pouvant aller jusqu’à environ 70 % en valeurs instantanées dans les conditions favorables d’un réseau fortement chargé (véhiculant une puissance élevée), comportant donc beaucoup d’alternateurs et de récepteurs tournants (moteurs) couplés au réseau.

La raison profonde de ces résultats est que, dans ces conditions, le réseau reste toujours « formé » par suffisamment d’alternateurs et conserve suffisamment d’inertie. Il reste donc dans le schéma connu du fonctionnement historique des réseaux. C’est d’ailleurs toujours le cas actuellement pour le réseau européen, le taux d’intégration d’électricité variable et intermittente ne dépassant pas 30 % environ en moyenne annuelle, valeur encore éloignée du taux limite de 40 % de l’étude précitée.

* La deuxième source est l’étude commune de RTE et de l’AIE de janvier 2021 [2] indiquant : « Quatre ensembles de conditions techniques strictes devront être remplies pour permettre, avec une sécurité d’approvisionnement assurée, l’intégration d’une proportion très élevée d’énergies renouvelables variables dans un système électrique de grande échelle, comme celui de la France [...] Il n'existe aucune démonstration de la faisabilité d'une intégration très poussée d'EnR variables comme l'éolien et le photovoltaïque sur un grand système électrique ».

Où en est-on trois ans plus tard de ces « Quatre ensembles de conditions techniques » ? « Leur faisabilité n’est pas aujourd’hui garantie » écrit sobrement RTE dans son Bilan prévisionnel 2023-2025 paru fin 2023, sans être plus explicite.

Ces conditions sont complétées par des alertes publiées par l’ENTSO-E (qui regroupe l’ensemble des GRT, gestionnaires des réseaux de transport européens, homologues de RTE). Elle concerne les risques liés à la diminution de l’inertie du réseau européen du fait de la diminution programmée du nombre de machines synchrones ([3] et [4]).

Ni RTE et l’AIE, ni l’ENTSO-E ne donnent de valeurs précises chiffrées des taux concernés d’intégration d’électricité variable et intermittente, mais ils sont qualifiés de « proportion très élevée » ou de « très poussés » d’évidence très supérieurs à 40 % en moyenne annuelle. Autrement dit, dans les cas envisagés ci-dessus, le réseau se trouve a priori dans une situation où il n’est plus majoritairement « formé » par des alternateurs. On entre alors dans une zone inconnue de fonctionnement, dépourvue à ce jour de références validées théoriquement et surtout par l’expérience sur des réseaux réels.

Ce point est d’importance stratégique majeure. En effet :

- À long terme, s’il se confirme qu’il est impossible de faire fonctionner des réseaux avec des taux très élevés d’électricité variable et intermittente, ce qui semble très probable, c’est l’illusion du « 100 % renouvelable » qui s’écroule de façon définitive pour ceux qui misaient sur cette solution idéalisée ;

- À court et moyen termes, ces considérations orientent d’ores et déjà les décisions eu égard au temps long (plusieurs décennies) d’évolution des infrastructures électriques. De ce point de vue, 2040-2050 c’est déjà demain. Et comme il s’agit d’infrastructures classées « d’importance vitale » (en tout cas en France), elles ne peuvent être programmées que sur la base de technologies déjà éprouvées. Attendre d’hypothétiques innovations radicales dans ce domaine constituerait un pari extrêmement risqué.

Il en résulte qu’il paraît actuellement pour le moins très risqué d’envisager un taux d’intégration significativement supérieur à 40 % en moyenne annuelle. Ce d’autant plus qu’atteindre ce taux dans un mix électrique qui devra être totalement décarboné en 2050 sera très loin d’être facile : il faudra en effet produire les 60 % restants d’électricité décarbonée à partir de moyens pilotables. Or, il existe peu de moyens possibles pour ce faire. L’étude précitée d’EDF R&D prévoyait d’atteindre 20 % de production à partir d’hydraulique et de biomasse en 2030. Mais la consommation d’électricité étant appelée à augmenter fortement entre 2030 et 2050, cette proportion diminuera mécaniquement sachant que les possibilités d’extension de ces deux sources d’énergies sont limitées et pourraient ne plus représenter qu’une dizaine de % en ordre de grandeur en 2050, en France en particulier. Il resterait donc à produire les 50 % restants de façon décarbonée. Comment ?

L’étude repart des bases de l’étude d’EDF R&D pour les appliquer à deux mix de 950 TWh/an, dont l’un est à peu près représentatif en 2045 du choix de l’Allemagne, refusant le nucléaire et comptant sur un mix comportant un taux très élevé de production d’électricité éolienne et photovoltaïque, l’autre étant représentatif en 2050 du choix de la France, ayant pérennisé l’option nucléaire à long terme. Le nucléaire devra alors fournir au moins 50 % de l’électricité annuelle du pays et si possible davantage, afin de limiter les inconvénients de taux élevés d’électricité variable et intermittente (il y a un intérêt économique majeur à ne pas dépasser 30 % selon plusieurs études).

Les principaux résultats des simulations de ces deux mix sont résumés ci-après :

* Concernant le mix allemand de type « 100 % renouvelable » plusieurs possibilités sont à examiner :

- Un schéma purement « 100 % renouvelable » (plan A) qui impliquerait de réussir à faire fonctionner un réseau majoritairement « formé » et piloté par des moyens couplés électroniquement (onduleurs), avec très peu de machines synchrones résiduelles. Il est à exclure, rien actuellement ne permettant de garantir que ce schéma soit viable. Ce serait un PARI très risqué sur la viabilité technique du système électrique.

- Une première voie de secours (plan B) consisterait à recréer artificiellement un système de production pilotable à partir de stockages de très grandes quantités d’hydrogène décarboné utilisé ensuite selon les besoins dans des moyens thermiques pilotables « compatibles hydrogène », cycles combinés (CCG) et turbines à combustion (TAC). Ce schéma fonctionne techniquement de façon certaine (on revient à un système électrique connu, majoritairement « formé » par des machines synchrones). Mais cela impliquerait d’énormes pertes énergétiques qui devraient être compensées par des dimensionnements physiques exorbitants en moyens éoliens et photovoltaïques ainsi qu’en électrolyseurs, qui poseraient clairement la question du réalisme de leurs dimensionnements et des coûts associés. C’est donc un PARI sur la capacité à produire ET à importer des quantités colossales d’hydrogène décarboné : plus de 500 TWh/an d’importations de ce gaz seraient en effet nécessaires. L’Allemagne, qui a compris qu’elle ne pourrait produire tout l’hydrogène dont elle aura besoin, a d’ailleurs prévu d’importer des quantités de cet ordre de grandeur, selon réf. [5].

- Une deuxième voie de secours (plan C) consisterait à continuer à utiliser le gaz (très majoritairement fossile compte tenu des quantités nécessaires) et à décarboner la production d’électricité associée par la capture et la séquestration du carbone (CCS en anglais). Mais les consommations énergétiques élevées et les incertitudes technico-économiques de cette technologie encore au stade de premiers projets industriels sans réels retours d’expérience, ainsi que les réseaux de CO2 et les capacités de stockage nécessaires à créer, aux coûts inconnus, rendent difficile de s’engager dans cette voie, sachant que plus de 200 Mt de CO2, quantité extrêmement importante, devraient être captés et séquestrés chaque année. C’est cette fois un PARI sur l’échelle des moyens de CCS à mettre en œuvre et in fine sur la décarbonation du mix en cas d’insuffisance physique de ces moyens, la porte de sortie facile et peu coûteuse étant alors de ne pas tout décarboner... Mais serait catastrophique pour le climat.

Au total, les impossibilités ou incertitudes majeures soulevées par les plans A, B ou C montrent que produire 950 TWh/an d’électricité décarbonée avec peu d’hydraulique et en se privant totalement de nucléaire, seule énergie à la fois décarbonée, pilotable, capable de produire de grandes quantités d’électricité à prix compétitif, apparaît comme extrêmement incertain, difficile et coûteux.

* Concernant le mix « nucléaire majoritaire » français, sa faisabilité technique est acquise et éprouvée.

Mais cela ne signifie pas qu’il sera facile de produire 950 TWh/an d’électricité décarbonée en France en 2050, avec un mix comportant au moins 50 % de nucléaire, nécessitant une capacité nucléaire installée minimale de 76 GW, qu’il sera hautement souhaitable d’augmenter pour limiter les inconvénients de taux d’intégration élevés d’électricité variable et intermittente. De plus, cet objectif ne pourra être atteint que par la combinaison de la prolongation de la majorité des réacteurs actuels jusqu’à 70 à 80 ans et la construction d’au moins 14 EPR2 et si possible davantage d’ici 2050.

L’enjeu est ici essentiellement industriel mais la tâche est immense et appelée à se prolonger bien au-delà de 2050 avec l’arrêt des réacteurs existants qu’il faudra bien remplacer un jour et l’émergence de réacteurs RNR pour utiliser au mieux la ressource énergétique totale de l’uranium.

Ce sont les conditions pour disposer de suffisamment d’électricité décarbonée aux horizons considérés.

*******

Étude justificative

1 - Rappels des principes actuels de réglage en fréquence-puissance des réseaux

2 - Limites physiques d’intégration d’ENR variables et intermittentes considérées comme à peu près acquises actuellement

3 - Peut-on aller bien au-delà des conclusions de l’étude d’EDF R&D de 2015 ?

- Les défis techniques des couplages électroniques au réseau

- Pourra-t-on gérer les très grandes variations d’amplitudes de l’éolien et du photovoltaïque ?

4 - Comparaison de deux mix que tout oppose : « 100 % renouvelable » versus « nucléaire majoritaire »

- Dimensionnements des mix nécessaires

- Estimation approximative des coûts de production de l’électricité

5 - Synthèse et conclusions

*******

1 – Rappels des principes actuels de réglage en fréquence-puissance des réseaux

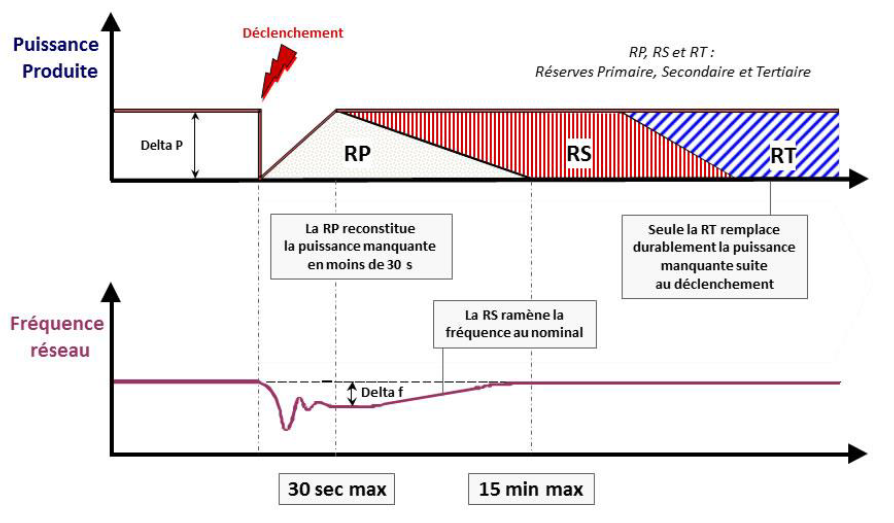

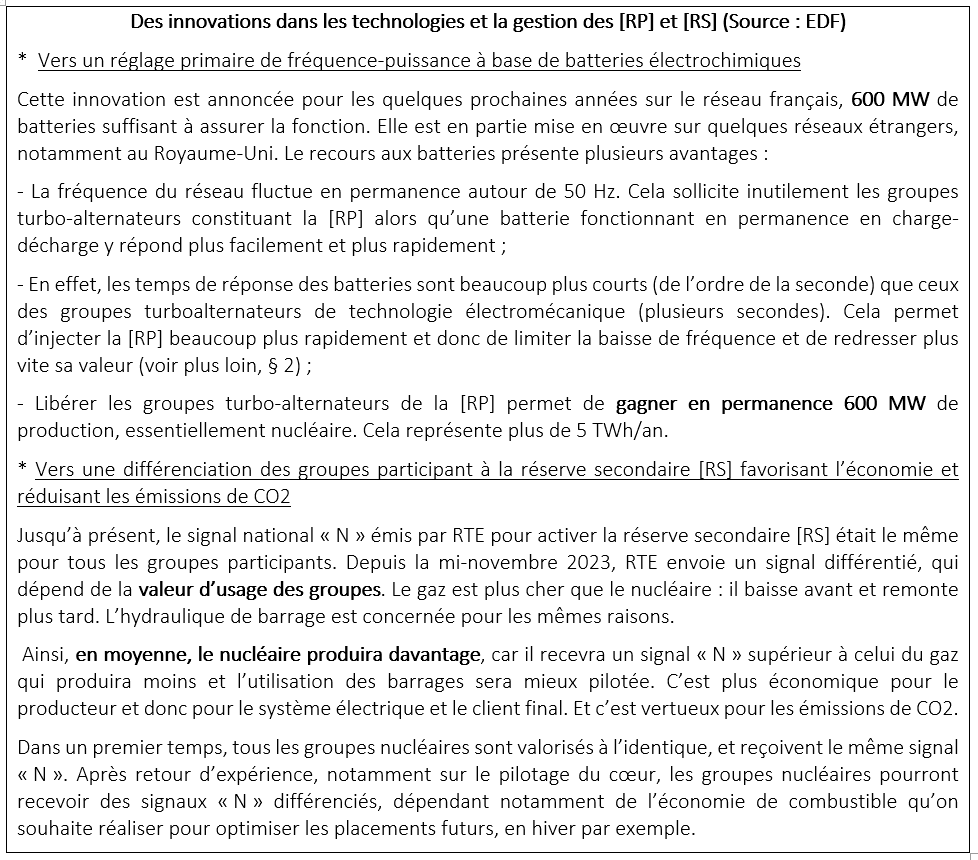

L’équilibre production-consommation d’un réseau électrique devant être assuré à tout instant afin de maîtriser la fréquence dans des limites très étroites (<< ± 1%), les perturbations dues aux variations permanentes de la demande ont de longue date dû être compensées par des moyens fondés sur le recours à trois types de « réserves de puissance » successivement mises en œuvre : les réserves Primaire [RP], Secondaire [RS] et Tertiaire [RT] dont les actions sont illustrées dans les schémas suivants :

Les principes de gestion de ces réserves et leurs principales caractéristiques sont résumés ci-dessous (Règles communes ENTSO-E au niveau européen) :

* Réserve Primaire [RP] : elle a pour but de reconstituer le plus rapidement possible le ΔP manquant suite à un incident. C’est une responsabilité partagée par l’ensemble des pays européens interconnectés. Sur la plaque synchrone continentale européenne à laquelle la France appartient, la perte de référence ΔP prise en compte est de 3 000 MW (en fait, perte simultanée de 2 groupes N4, les plus puissants du réseau européen à ce jour). La quote-part de la France est d’environ 600 MW, qui doivent être injectés en moins de 30 s. La constitution de cette réserve est obtenue en faisant fonctionner suffisamment de groupes synchrones à un maximum de 98 % de leur puissance nominale Pn de sorte qu’ils puissent moduler rapidement leur puissance de ± 2 %.

L’injection de puissance se fait selon une loi de régulation proportionnelle du type : ΔP = – K x Δf. C’est une régulation totalement automatique et purement locale (qui agit au niveau de chaque groupe de production participant au réglage), très simple, mais qui ne permet pas de ramener Δf à 0 (puisque le ΔP diminue au fur et à mesure que le Δf diminue, il faudrait donc un temps infini pour retrouver 50 Hz). A noter que la sous-fréquence après un incident de perte de puissance est commune à l’ensemble des pays de la plaque européenne interconnectée.

* Réserve Secondaire [RS] : elle a précisément pour but de ramener la valeur de la fréquence à 50 Hz. On utilise pour cela une injection de puissance selon une loi de régulation à la fois proportionnelle et intégrale du type : ΔP = – [K1 x Δf + K2 x ∫ Δf]. C’est une régulation également automatique mais télécommandée par un signal national « N » émis par RTE variant dans une plage de ± 1. La [RS] agit à partir de 30 s et doit atteindre sa valeur maximum d’environ 1 200 MW en France en 15 mn maximum. Elle sert en outre à reconstituer la réserve primaire. La constitution de la [RS] est obtenue en faisant fonctionner suffisamment de groupes synchrones à un maximum de 95 % de leur puissance nominale Pn de sorte qu’ils puissent moduler rapidement leur puissance de ± 5 %. Certains groupes participants, en particulier nucléaires, peuvent cumuler les [RP] et [RS]. Ils fonctionnent alors à un maximum de 93 % de leur puissance nominale Pn pour être capables de moduler leur puissance de ± 7 %.

Point majeur : la responsabilité de ramener la fréquence du réseau européen à 50 Hz n’est plus partagée, elle appartient au pays ayant subi la perte de puissance. S’il n’a pas les moyens de production nécessaires, il doit importer la puissance nécessaire de pays voisins à titre onéreux jusqu’à ce que la fréquence soit ramenée à 50 Hz.

* Réserve Tertiaire [RT] : elle permet de reconstituer la [RS] pour faire face à un nouvel incident. Elle doit pour cela pouvoir injecter environ 1 500 MW sur le réseau français en moins de 30 mn, dont 1 000 MW en moins de 15 mn. La gestion de cette réserve n’est plus automatique mais pilotée par une action humaine. Enfin, [RS] + [RT] sont dimensionnées pour pouvoir reconstituer la perte du plus gros groupe du réseau en moins de 15 mn. Eu égard aux délais de mobilisation assez courts de la [RT], sa plus grande partie doit être constituée de « réserve tournante » ayant la capacité de monter suffisamment vite en puissance. Mais cela résulte aussi de la situation du réseau, des réserves hydrauliques, etc., une optimisation technico-économique étant faite en permanence.

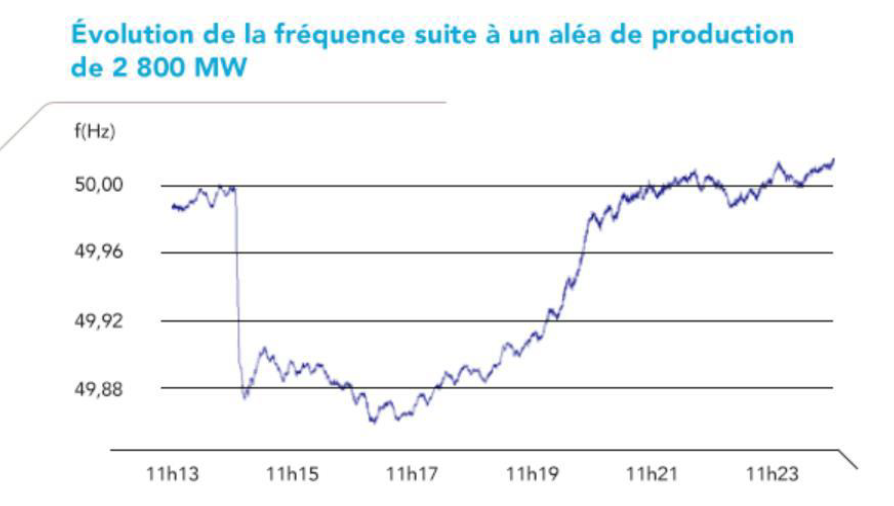

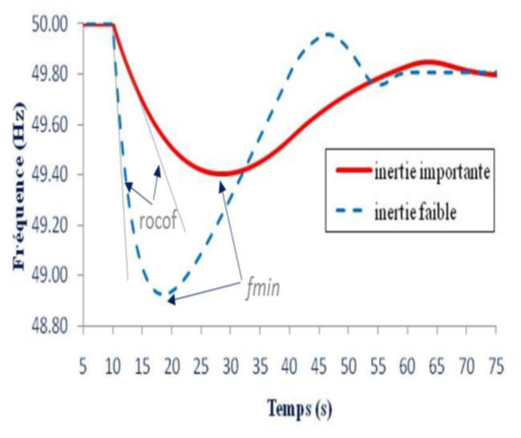

Un exemple réel de variation de fréquence est donné sur la figure 1 ci-dessous :

Cet exemple fait apparaître un premier fmin après environ 10 s (∆f max ≈ - 140 mHz) et un bon fonctionnement des [RP] et [RS], avec une remontée rapide due à la [RS] et une récupération de la fréquence nominale après environ 7 mn << 15 mn prescrites.

Physiquement, l’atteinte de fmin en environ 10 s traduit l’effet de l’inertie importante du réseau. La suite de l’évolution est complexe à interpréter, avec une première remontée résultant des premiers effets de la [RP] qui se superposent à l’oscillation naturelle de remontée de fréquence. Ensuite, il y a sans doute une deuxième oscillation à laquelle se superposent les [RP] et [RS] pour finir uniquement par cette dernière, avec une évolution qui devient alors très lisible.

Il faut noter que ramener à 50 Hz (à ± ε du fait de petites fluctuations permanentes) la fréquence de la plaque synchrone du réseau européen interconnecté implique physiquement de reconstituer l’énergie cinétique de l’ensemble des groupes synchrones qui y sont couplés.

* Enfin, au-delà des trois réserves rappelées ci-dessus qui permettent la gestion des incidents dus à des pertes de moyens de production, il existe un besoin en modulation de puissance : le « suivi de charge », c’est-à-dire l’adaptation permanente à très court et court terme de la puissance aux variations de la demande. Ce « suivi de charge », autrefois limité aux seules compensations des variations de la consommation, est en train de devenir de plus en plus important dans la mesure où il doit aussi et surtout compenser les variations des puissances éoliennes et photovoltaïques, d’amplitudes de plus en plus importantes et très supérieures à celles de la seule consommation et accompagnées de bien plus forts gradients horaires de puissance. Cela fait partie des défis d’importance croissante qui, en l’absence de capacités de stockage de masse d’énergie, sollicitent massivement les moyens pilotables. Rien qu’avec les puissances actuellement installées en éolien (≈ 26 GW) et en PV (≈ 17,5 GW) on observe des besoins de modulation qui se situent couramment vers 10 à 12 GW et peuvent aller jusqu’à 20 GW en quelques heures.

Ces modulations se font d’abord à partir des moyens flexibles hydrauliques et au gaz, mais elles sont de trop faibles amplitudes et seul le parc nucléaire est capable d’assurer des modulations de l’ampleur précitée, en utilisant les capacités de modulation profonde des réacteurs, pouvant atteindre 80 % de Pn en 30 mn (passage de 100 % à 20 % Pn en 30 mn et remontée possible si nécessaire à la même vitesse après 2 heures de stabilisation intermédiaire). La quasi-totalité du parc nucléaire peut être géré de cette manière, à l’exception des 4 réacteurs 900 MW de Bugey non équipés de barres grises et des 4 réacteurs N4 qui n’ont pas été équipés d’origine du mode de réglage permettant d’atteindre cette flexibilité. Leurs contributions restent cependant possibles, mais elles sont moins flexibles.

2 – Limites physiques d’intégration d’ENR variables et intermittentes considérées comme à peu près acquises actuellement

Comme rappelé plus haut au §1, le maintien de la fréquence des réseaux dans une plage de variations très étroite (<< ± 1%) conditionne au premier ordre leur sûreté globale de fonctionnement, des écarts de fréquence trop importants (au-delà de ± 0,8 Hz, limite de sécurité de l’ENTSO-E, pour fixer les idées) pouvant conduire, s’ils ne sont pas maîtrisés très rapidement, à une défaillance très étendue, voire généralisée (black-out).

L’étude EDF R&D citée dans le résumé s’inscrit complètement dans le strict respect des règles de fonctionnement et de sécurité actuelles en limitant à 40 % en moyenne annuelle le taux global d’intégration d’électricité variable et intermittente. Elle met aussi en évidence que le taux instantané maximum d’intégration est très variable et dépend au premier ordre de l’inertie du réseau, elle-même fonction de la charge du réseau. Ce taux est limité à environ 25 % pour un réseau peu chargé, comportant peu de turbo-alternateurs couplés et peu de récepteurs tournants qui apportent également leur inertie à condition d’être couplés directement au réseau et non via des onduleurs de plus en plus utilisés pour faciliter leur démarrage et permettre d’optimiser leur vitesse pour économiser l’énergie. Il peut par contre atteindre environ 70 % lorsque le réseau est très chargé, par conséquent avec beaucoup de turbo-alternateurs couplés et de récepteurs tournants alimentés.

Ce résultat est lié à l’importance cruciale de l’inertie du réseau pour assurer sa stabilité, l’ENTSO-E ayant chiffré à environ 150 GW la puissance minimale en turbo-alternateurs devant être couplée au réseau synchrone de la plaque continentale européenne pour garantir sa stabilité. À titre indicatif, le réseau français représentant environ 17 % du réseau précité, sa quote-part en apport d’inertie est de l’ordre de 150 x 0,17 ≈ 25 GW minimum. Il faut cependant noter que grâce aux interconnexions, un pays donné peut avoir moins d’inertie que sa quote-part en % si les pays voisins en ont davantage que la leur, de sorte que le critère soit globalement respecté pour la plaque européenne. Le respect de la quote-part est cependant un atout en cas de séparations de réseaux, incidents rares mais redoutables.

Parmi les autres conclusions apportées par l’étude d’EDF R&D on retiendra en résumé que l’atteinte d’un taux d’intégration de 40 % de sources variables et intermittentes en moyenne annuelle suppose des conditions complémentaires intervenant au second ordre, dont notamment :

* Mettre en œuvre des moyens limités de stockage/déstockage d’énergie et d’effacements et/ou reports de consommations ;

* Faire contribuer les sources variables et intermittentes aux « services système » (en particulier réglages de fréquence et participation aux réserves). Mais ces contributions restent très limitées et temporaires dans la mesure où les apports possibles à la hausse de puissance sont aléatoires (ils peuvent être contrariés par une baisse temporaire et imprévisible de vent ou d’ensoleillement) si bien que seules les réductions de puissance (par arrêts de production d’éoliennes ou de panneaux photovoltaïques) sont réellement fiables.

* Se préparer à faire face dès 2030 à des rampes de puissance pouvant atteindre 400 GW entre un dimanche ensoleillé et/ou venté et un lundi sans soleil et/ou avec vent très faible et une forte reprise de la consommation. En effet, les variations des productions intermittentes vont devenir beaucoup plus importantes et souvent beaucoup plus rapides que celles de la seule consommation ;

* Il résulte de ce qui précède que des puissances pilotables importantes devront rester disponibles :

- Soit pour compenser les très grandes variations de puissance induites par les variations de l’éolien et/ou du photovoltaïque, ce que les autres moyens envisagés (stockages/déstockages et flexibilité de la demande) ne pourront jamais faire à cette échelle ;

- Soit pour être démarrées préventivement et couplées au réseau avec écrêtement associé des sources éoliennes et/ou photovoltaïques pour maintenir la fréquence du réseau dans les limites de sécurité, en particulier au-dessus de la fréquence basse de sécurité du réseau.

Au vu de ces différentes conditions, il est facile de comprendre que la gestion de l’équilibre instantané des réseaux va se complexifier fortement avec l’augmentation du taux d’intégration de sources variables et intermittentes, nécessitant probablement l’utilisation d’intelligence artificielle (IA), autre évolution majeure qui reste à mettre au point et recèle de nouvelles difficultés et vulnérabilités en termes de cyber-risques.

L’Europe est cependant encore loin d’être parvenue au stade décrit dans l’étude d’EDF R&D. Le taux d’intégration des sources variables et intermittentes sur la plaque européenne y est encore inférieur à 30 % en moyenne annuelle avec une très grande dispersion selon les pays, soit environ 57 % au Danemark, 39 % en Allemagne, 38 % en Espagne, 34 % aux Pays-Bas, 17 % en Italie, 14 % en France, 11 % en Pologne et de très faibles taux dans la plupart des autres pays de l’Est.

Le système électrique européen n’a donc pas encore expérimenté les difficultés réelles d’un taux d’intégration de 40 % d’électricité variable et intermittente, ce d’autant moins que le nucléaire français, avec ses grandes unités nucléaires qui apportent énormément d’inertie au réseau européen via ses très nombreuses interconnexions, a fréquemment un effet stabilisateur sur la fréquence de la plaque européenne synchrone. Les difficultés restent donc très largement à venir et donc à découvrir...

Toutefois, une île européenne relativement isolée fait exception : l’île irlandaise, qui regroupe l’Irlande du Nord (Royaume-Uni) et la République d’Irlande (UE). Pour des raisons évidentes, ces deux pays ont néanmoins décidé de gérer en commun leurs deux réseaux, avec un GRT unique, EIRGRID GROUP. Ce réseau est peu interconnecté au réseau du RU, par seulement deux liaisons en courant continu de 0,5 GW chacune (une autre, de 0,7 GW avec la Bretagne, est en cours de construction). L’intégration de sources variables et intermittentes y est donc plus difficile que sur la plaque européenne fortement interconnectée, ce qui en fait une sorte de « laboratoire avancé » pour l’Europe.

EIRGRID GROUP (réf.[6]) indique avoir atteint en 2020/2021 un taux d’intégration d’éolien (il y a très peu de photovoltaïque sur l’île) d’environ 40 % en moyenne annuelle et de 70 à 75 % en valeur instantanée maximale, soit à peu près les résultats de l’étude d’EDF R&D pour la plaque européenne. Ce résultat est obtenu grâce à deux facteurs :

* Des prévisions météorologiques de plus en plus fiables et précises qui permettent d’anticiper les productions éoliennes et de prendre des mesures préventives telles que le démarrage préventif de moyens pilotables ;

* L’existence d’un parc pilotable très important (en 2021) : outre 2,8 GW de charbon et de fioul, un parc de 5,8 GW de CCG et TAC au gaz, dont le fonctionnement est très flexible, face à un parc éolien de 5,6 GW installés à la même date, le tout pour satisfaire une demande d’environ 5 GW en valeur moyenne et de moins de 7 GW en pointe. En un mot, EIRGRID GROUP dispose pratiquement d’un double parc de production pour s’adapter très rapidement aux fluctuations de l’éolien, à la fois instantanées et plus lentes mais de plus grande amplitude, pouvant atteindre 1 000 à 1 500 MW/heure. Cependant, en dépit des taux d’intégration d’éolien élevés annoncés, le bilan carbone de cette production d’électricité restait assez médiocre, autour de 300 g/kWh et cela ne semble pas avoir beaucoup changé.

EIRGRID GROUP (réf. [7]) annonce par ailleurs de grandes ambitions pour 2030 : atteindre un taux d’intégration d’environ 70 % en moyenne annuelle et de 85 à 95 % en valeur instantanée maximale pendant 60 % du temps. Des études approfondies engagées par ce groupe avec des collaborations européennes, l’Europe étant évidemment très intéressée par l’expérience irlandaise, montrent cependant que cet objectif est très loin d’être facile à atteindre pour de multiples raisons explicitées plus loin au § 3. En tout état de cause, seul le retour d’expérience en exploitation réelle de ce réseau permettra de conclure sur la faisabilité et la viabilité technique et économique d’un tel fonctionnement ainsi que sur sa sécurité d’alimentation, paramètre essentiel.

3 – Peut-on aller bien au-delà des conclusions de l’étude d’EDF R&D de 2015 ?

L’histoire ne s’est évidemment pas arrêtée en 2015 et, face aux nouveaux enjeux d’intégration de quantités croissantes d’électricité variable et intermittente, plusieurs programmes de R&D ont été engagés dans le monde et plus particulièrement en Europe, notamment dans le cadre de coopérations européennes sous l’égide de l’UE, auxquelles EDF et RTE, ainsi que des laboratoires et des industriels du secteur électrique français ont participé. Il s’agit en particulier des projets :

* MIGRATE (réf. [8] et OSMOSE réf. [9]) dont les objectifs ont été d’étudier puis ensuite d’expérimenter, grâce à des démonstrateurs isolés de petite taille, la stabilité d’un réseau avec une part majoritaire d’électricité intermittente, impliquant une proportion très élevée de moyens de production couplés via des onduleurs électroniques de puissance ;

* EU-SysFlex (réf.[10]), dont l’objectif a été d’étudier l’intégration systémique de sources variables et intermittentes, associées aux moyens de stockages/déstockages d’énergie, à la flexibilités des moyens de production et des consommations, etc. et à leur pilotage par les technologies dites de « réseaux intelligents » (« Smartgrids » en anglais) faisant appel à l’IA en prenant en compte tous les aspects : faisabilité technique, impact environnemental (minimisation des émissions de CO2 des mix électriques retenus), sécurité d’alimentation, aspects règlementaires, coûts, fonctionnement des marchés, etc.

Un objectif d’intégration d’au moins 50 à 55 % en production moyenne annuelle de sources variables et intermittentes a été retenu pour ce projet d’étude.

Les résultats de ces projets ont été publiés en décembre 2021. Ils précisent les premiers acquis et les pistes possibles pour aller plus loin. Mais toutes les questions n’ont semble-t-il pas eu de réponses et de nouvelles études et expérimentations semblent indispensables avant un possible déploiement en vraie grandeur sur des réseaux réels en exploitation, opération qui serait très difficile sachant que pendant de tels essais, il sera indispensable de garantir la continuité d’alimentation des consommateurs en toute sécurité. RTE reste très discret sur cette phase qui semble encore bien lointaine...

En résumé, l’intégration dans les réseaux de taux très élevés d’électricité variable et intermittente, éolienne et/ou photovoltaïque, a deux conséquences majeures :

* Elle implique une révolution technologique, l’éolien et le photovoltaïque étant couplés au réseau via des onduleurs électroniques de puissance et non plus via des machines synchrones comme les moyens actuels. Les conséquences en sont pour la plupart négatives à quelques exceptions près.

* Les variations de très grandes amplitudes de l’éolien et du photovoltaïque déstabilisent profondément les réseaux et compliquent considérablement leur gestion physique et économique.

Ces deux points sont précisés ci-après :

- Les défis techniques des couplages électroniques au réseau

La machine de base des réseaux actuels fonctionnant en courant alternatif est l’alternateur triphasé, inventé en 1891 par Nikola Tesla qui travaillait aux Etats-Unis pour George Westinghouse. Depuis cette date, ils ont été constamment améliorés jusqu’à devenir capables de produire des puissances extrêmement élevées (jusqu’à ≈ 1 800 MW actuellement) et présentent des caractéristiques que l’on peut qualifier d’exceptionnelles, comparées à celles des onduleurs électroniques :

1 - Les alternateurs permettent de « former » des réseaux électriques triphasés en fréquence f et en tension U, qui sont les deux paramètres principaux caractérisant un réseau ;

Les onduleurs actuellement utilisés, dits « suiveurs » (« grid following » en anglais) ne le permettent pas, ils ont impérativement besoin d’un réseau déjà « formé » pour injecter leur puissance. On a donc inventé des onduleurs dits « formeurs » (« grid forming » en anglais) qui ont la capacité théorique de reproduire électroniquement (informatiquement) les lois physiques internes des alternateurs. Cependant, leur capacité physique réelle à le faire n’est pas démontrée à ce jour (voir ci-dessous). De plus, ces onduleurs dont le fonctionnement est informatisé, sont par nature cyber-vulnérables, alors que des alternateurs qui fonctionnent à très haute énergie selon les lois de l’électromagnétisme ne le sont absolument pas (seules leurs liaisons de contrôle-commande avec l’extérieur peuvent l’être, mais cela vaut dans les deux cas).

2 - Plusieurs alternateurs couplés en parallèle à un même réseau fonctionnement de façon parfaitement stable s’ils sont munis de régulateurs de puissance-fréquence très simples utilisant une loi de la forme ΔP = – K x Δf (voir § 1). Et une fois couplés au réseau, leur rotors sont tous couplés entre eux via des couples électromagnétiques très puissants qui permettent de faire varier leurs vitesses de rotation en synchronisme, c’est-à-dire de faire varier la fréquence commune du réseau. Ce quel que soit leur nombre (les variations de fréquence se propagent sur les réseaux en une fraction (≈ 2/3) de la vitesse de la lumière dans le vide : la fréquence est donc pratiquement identique partout à tout instant).

Comme indiqué ci-dessus, le fait que les onduleurs dits « formeurs », qui sont couplés au réseau par des moyens purement électroniques, donc à basse énergie, n’aient pas la capacité démontrée à ce jour de pouvoir fonctionner en parallèle et en grand nombre sur les réseaux est un point d’arrêt majeur, car susceptible d’interdire le fonctionnement des réseaux avec un taux très élevé d’électricité variable et intermittente.

3 - Les alternateurs possèdent une grande inertie mécanique (celle de leur rotor et de la turbine qui les entraîne) dont le cumul constitue l’essentiel de l’inertie du réseau, indispensable à sa stabilité et qui laisse en outre aux régulateurs de puissance-fréquence des groupes turbo-alternateurs le temps d’agir pour équilibrer à tout instant la production et la consommation.

L’impact type de l’inertie sur les transitoires de fréquence d’un réseau est illustré sur la figure 2 ci-dessous (source : EDF) qui montre que plus l’inertie est faible, plus la variation de fréquence est rapide et plus la fréquence chute profondément au cours du transitoire, donc plus le système est déstabilisé.

NB : sur cette figure, le « rocof » ou « rate of change of frequency » est le taux de variation de la fréquence à l’origine de l’incident. Il s’exprime en Hz/s et est proportionnel à la perte de puissance et inversement proportionnel à l’inertie résiduelle du réseau.

À titre indicatif, la fréquence minimale fmin est atteinte en 10 à 15 s sur le (grand) réseau métropolitain français, fortement interconnecté au réseau européen, mais en largement moins de 5 s sur les (petits) réseaux isolés des îles DOM-TOM, alimentés par de petites machines, dont les rotors ont peu d’inertie.

Les onduleurs électroniques de puissance n’ont évidemment aucune inertie mécanique. Augmenter le taux d’éolien et/ou de photovoltaïque dans un réseau réduit donc le nombre d’alternateurs couplés à ce dernier et par conséquent son inertie globale, ce qui accroît à la fois la rapidité et l’amplitude des variations de fréquence et diminue en conséquence la stabilité et la sécurité de fonctionnement du réseau.

Les études d’EIRGRID GROUP pour le réseau irlandais montrent que le rocof ne doit en aucun cas descendre au-dessous de 1 Hz/s, sous peine de rendre le réseau de l’île incontrôlable. La raison en est facile à comprendre : aucun moyen connu à ce jour ne permet de compenser suffisamment vite la puissance perdue pour éviter une chute très rapide et profonde de la fréquence et son franchissement de la limite basse de fréquence conduisant au black-out. Même un ensemble [batterie + onduleur] qui permet une injection de la puissance nominale de la batterie en ≈ 1 s ne le permet pas.

Concernant le réseau synchrone interconnecté de la plaque européenne, des études réalisées par l’ENTSO-E (réf. [3] et [4]) montrent que des rocof < 1 Hz/s pourraient être atteints à l’avenir en cas de séparations de réseaux à l’intérieur de la plaque synchrone européenne. De telles séparations peuvent en effet induire des pertes de puissance très supérieures à celles des pertes de moyens de production actuellement prises en compte, soit 3 000 MW (§ 1). L’ENTSO-E en conclut qu’il sera indispensable à l’avenir d’augmenter l’inertie du réseau européen, soit en maintenant des turbo-alternateurs couplés en permanence au réseau, soit en ajoutant un grand nombre de « compensateurs synchrones » : ces machines, utilisées de longue date pour régler la tension du réseau, ne sont rien d’autre que des alternateurs couplés au réseau sans fournir de couple moteur. Mais ils apportent l’inertie de leur rotor.

En résumé, même si cette dernière solution éprouvée existe, la question de l’inertie est et restera un paramètre crucial pour les réseaux intégrant un taux très élevée d’éolien et/ou de photovoltaïque.

4 - Les alternateurs possèdent également une grande inertie thermique du fait de leur structure électromécanique et de leur système de refroidissement interne. Cela leur permet de supporter sans dommages des surintensités très importantes (jusqu’à 500 à 600 % l’intensité nominale) pendant de courts instants, ce qui permet de ne pas les déconnecter du réseau lors de courts-circuits fugitifs sur les réseaux, qui sont les plus fréquents, et par conséquent de reprendre immédiatement leur production dès le défaut éliminé, ce qui constitue un facteur majeur de la sécurité d’alimentation.

Ce n’est pas le cas des onduleurs électroniques de puissance, qu’ils soient « suiveurs » ou « formeurs » dans la mesure où leurs composants électroniques ont très peu d’inertie thermique et ne sont capables de supporter que des surintensités généralement comprises entre 20 % et 80 % de leur intensité nominale, selon leur construction. Aller beaucoup plus loin renchérirait énormément leurs coûts.

5 - Les alternateurs produisent des ondes de tension et de courant de formes quasi-sinusoïdales, donc pratiquement sans harmoniques à haute fréquence.

Ce n’est pas le cas des onduleurs, qu’ils soient « suiveurs » ou « formeurs », dans la mesure où ils fonctionnent par hachage de courant continu, ce qui génère des harmoniques de haute fréquence, pouvant aller jusqu’à 150 kHz. Ces harmoniques ont des effets délétères sur les matériels et sur les équipements des réseaux, en particulier sur les capteurs, mais également sur les équipements des consommateurs s’ils ne sont pas éliminés. Il existe cependant des solutions simples pour ce faire, à savoir l’installation de filtres dits « passe-bas » déjà utilisés dans certaines circonstances mais qui devront être généralisés avec l’augmentation du taux d’intégration d’onduleurs dans les réseaux.

6 – Pour résumer, les nouvelles problématiques citées ci-dessus, résultant des couplages électroniques indispensables pour connecter au réseau les sources éoliennes et photovoltaïques sont loin d’être exhaustives. Bien d’autres pourraient être évoquées, notamment la difficulté à disposer de réserves primaire, secondaire et tertiaire (§1) ainsi que des possibilités de suivi de charge qui impliquent des capacités de stockage pouvant être très importantes.

Mais deux sujets émergent de par leur importance cruciale pour garantir la structuration, la stabilité et la sécurité d’alimentation non dégradée des futurs réseaux par rapport à la situation actuelle :

* La capacité à « former » les futurs réseaux en fréquence f et en tension U ;

* La nécessité d’apporter aux réseaux une inertie suffisante.

La combinaison de ces deux conditions implique actuellement de maintenir suffisamment de machines synchrones (turbo-alternateurs et/ou compensateurs synchrones) couplées en permanence au réseau. Pour en comprendre les raisons, le plus simple est de considérer deux cas bien différenciés :

° Celui d’un taux d’intégration d’électricité variable et intermittente ne dépassant pas 40 % en moyenne annuelle, avec des taux instantanés se situant entre 25 % minimum et 70 % maximum selon que la charge en puissance du réseau est faible ou élevée, cas étudié en profondeur par EDF R&D. Le réseau reste, dans ces conditions, constamment formé par les alternateurs, dans un schéma connu et éprouvé de longue date, dont on peut observer la très grande fiabilité et sécurité d’alimentation actuelle.

° Celui d’un taux d’intégration d’électricité variable et intermittente très supérieur à 40 % en moyenne annuelle. On entre là dans un schéma totalement nouveau et actuellement très incertain, car non validé par l’expérience sur des réseaux réels, dans lequel les turbo-alternateurs deviennent très minoritaires (ne restent que ceux qui utilisent l’énergie hydraulique ou la biomasse). Ces seuls moyens synchrones deviennent alors très insuffisants pour « former » les réseaux en fréquence f et en tension U.

Il s’agit là d’un point d’incertitude majeur, contenu en filigrane dans l’étude commune de RTE et de l’AIE de janvier 2021 [2] qui indiquait : « Quatre ensembles de conditions techniques strictes devront être remplies pour permettre, avec une sécurité d’approvisionnement assurée, l’intégration d’une proportion très élevée d’énergies renouvelables variables dans un système électrique de grande échelle, comme celui de la France [...] Il n'existe aucune démonstration de la faisabilité d'une intégration très poussée d'EnR variables comme l'éolien et le photovoltaïque sur un grand système électrique ».

Trois ans plus tard, cette incertitude est la même concernant ces « Quatre ensembles de conditions techniques » : « Leur faisabilité n’est pas aujourd’hui garantie » écrit sobrement RTE dans son Bilan prévisionnel 2023-2025 paru fin 2023, sans être plus explicite.

Plusieurs hypothèses se présentent alors pour l’avenir :

- Hypothèse 1 : grâce aux progrès technologiques à venir, on parvient à faire fonctionner les réseaux de façon stable et sûre avec un grand nombre d’onduleurs « formeurs » couplés en parallèle entre eux et avec les alternateurs résiduels et le problème est résolu. On notera cependant qu’un réseau « formé » de la sorte étant complètement inédit, de nombreuses autres surprises seraient à attendre lors de sa mise au point, avec cependant une certitude : compte tenu de son caractère très fortement numérisé, il serait beaucoup plus cyber-vulnérable qu’un réseau « formé » par des machines synchrones. Ce point serait une question centrale pour sa sûreté de fonctionnement, qui devrait obtenir une réponse d’une extrême fiabilité et robustesse eu égard aux risques encourus : la mise dans le noir de tout ou partie du pays.

Il faudrait en outre augmenter l’inertie du réseau, ce qui impliquerait d’installer un très grand nombre de compensateurs synchrones, solution connue et éprouvée qui permettrait également de régler la tension U du réseau. Et il faudrait aussi résoudre tous les autres problèmes évoqués ci-dessus et bien d’autres non évoqués.

NB : dans cette hypothèse, on utiliserait à la fois des onduleurs « formeurs » en nombre suffisant pour « former » le réseau et des onduleurs « suiveurs » comme actuellement qui ne font qu’injecter de la puissance.

- Hypothèse 2 : il s’avère très difficile voire impossible de faire fonctionner le réseau dans les conditions précitées dans l’hypothèse 1 et la seule solution est alors de conserver en permanence suffisamment de moyens pilotables synchrones pour « former » le réseau. Or, produire de l’électricité décarbonée pilotable en très grandes quantités sans recourir au nucléaire implique de disposer de stocks d’énergie décarbonée accumulés à partir d’électricité éolienne et/ou photovoltaïque. La seule solution physique connue à ce jour, à la très grande échelle requise, est d’utiliser le stockage de gaz décarbonés, le plus immédiat étant l’hydrogène décarboné. Ce dernier sera ensuite brûlé à la demande dans des cycles combinés (CCG) pour l’essentiel et dans des turbines à combustion (TAC) pour les ultra-pointes.

NB : la solution du biométhane n’a pas été retenue ici car ses quantités seront limitées et probablement beaucoup plus utiles dans d’autres applications, la mobilité par exemple.

Cette hypothèse 2 implique cependant trois conséquences supplémentaires majeures :

- Les moyens pilotables précités utilisant l’hydrogène doivent non seulement compenser les variations et l’intermittence des productions éoliennes et photovoltaïques, mais aussi « former » le réseau. Cette dernière fonction implique un fonctionnement permanent d’un nombre suffisant de groupes pilotables couplés au réseau et par conséquent une consommation permanente d’hydrogène, fonction de l’état du réseau ;

- Des capacités de stockages d’hydrogène très importantes sont nécessaires, y compris pour faire face à un manque durable de vent pouvant statistiquement durer jusqu’à une quinzaine de jours ;

- La production d’hydrogène décarboné à partir d’électricité éolienne et/ou photovoltaïque doit être considérablement augmentée du fait du faible rendement global de la chaîne de conversion :

Électricité --> Hydrogène --> Électricité

Ce rendement global est d’environ 33 % si l’hydrogène est brûlé dans un cycle combiné (CCG) à haut rendement et environ 22 % si c’est dans une turbine à combustion en cycle ouvert (TAC). Ce faible rendement global implique donc dans le meilleur des cas (CCG) de consommer donc de produire environ 3 kWh d’électricité VARIABLE ET INTERMITTENTE pour récupérer... 1 kWh d’électricité PILOTABLE.

Sur la base des critères de l’étude EDF R&D, seule 40 % de l’électricité éolienne et/ou photovoltaïque produite serait consommée directement. Le reste le serait pour produire de l’hydrogène destiné à faire fonctionner des moyens thermiques pilotables utilisant ce gaz, le double de cette quantité d’électricité étant perdue (2 kWh perdus par kWh pilotable produit).

En résumé, cette hypothèse revient donc à recréer artificiellement un parc de production pilotable à partir de stockages de très grandes quantités d’hydrogène, qui fonctionnera techniquement de façon stable et sûre mais devra auto-consommer en permanence environ les 2/3 de l’électricité variable et intermittente produite grâce aux éoliennes et aux panneaux photovoltaïques sous forme de pertes énergétiques.

- Hypothèse 3 : elle consiste à se passer de stockage de masse d’hydrogène et à continuer à utiliser le gaz (très majoritairement fossile compte tenu des très importantes quantités nécessaires) pour faire fonctionner des moyens thermiques pilotables, CCG et TAC, et à décarboner la production d’électricité qui en est issue par la capture et la séquestration du carbone (CCS).

Cette solution présente cependant de grandes difficultés et inconnues : elle est très énergétivore (elle absorbe l’équivalent d’environ 30 % de l’électricité pilotable produite) ; elle est industriellement très peu mature ; elle requiert des réseaux de transport et des stockages profonds du CO2 très importants, qui peuvent poser des problèmes environnementaux difficiles ; ses coûts sont actuellement totalement inconnus.

- Pourra-t-on gérer les très grandes variations d’amplitudes de l’éolien et du photovoltaïque ?

C’est une question majeure eu égard aux prévisions d’accroissement de ces sources d’énergies en France et plus encore en Europe, avec en particulier l’Allemagne qui, suite à l’abandon du nucléaire, mise tout sur les énergies renouvelables.

- En France

Rappelons (§ 1) que des besoins en modulation de puissance, qui se situent couramment vers 10 à 12 GW et peuvent aller jusqu’à 20 GW en quelques heures, sont déjà couramment observés avec les puissances actuellement installées en éolien (≈ 26 GW) et en PV (≈ 17,5 GW) à fin 2023.

Or, la PPE (programmation pluriannuelle de l’énergie) actuellement en cours d’élaboration mise pour 2035 sur une capacité en éolien (à terre et en mer) de 58 à 63 GW, dont 18 GW en mer (soit au total pratiquement la capacité nucléaire à la même date) et de 65 à 90 GW pour le photovoltaïque (soit jusqu’à pratiquement 1,5 fois la capacité nucléaire), pour un total général qui pourrait dépasser 150 GW. Si l’on retient les valeurs maximales, ce mix pourrait produire un peu plus de 250 TWh/an.

Les transitoires de puissance qui résulteront de ces capacités vont profondément modifier la gestion du réseau. On peut s’en faire une première idée sur la base de la production photovoltaïque, plus simple à analyser. Durant la période autour du solstice d’été ± 2 mois au cours de laquelle le soleil est au plus haut, 90 GW installés pourront produire jusqu’à environ 75 GW d’électricité par temps clair sur le pays, autour de l’heure solaire méridienne ± 1 à 2 h. Que fera-t-on de cette production lors des mois d’été durant lesquels la consommation d’électricité est faible, actuellement de l’ordre de 50 GW en semaine et peut descendre vers 40 GW et moins lors des week-ends ? Plusieurs éléments d’analyse :

* On pourra : produire de l’hydrogène ; remplir les bassins hauts des STEPs ; recharger les véhicules électriques branchés à des bornes. Cependant, la somme de ces consommations restera généralement très inférieure aux 30 à 40 GW de surplus photovoltaïques ;

* On ne pourra pas trop compter sur les exportations, une journée ensoleillée en France ayant de fortes chances de dépasser les frontières et de s’étendre aux pays voisins qui seront encore plus fortement équipés en photovoltaïque ;

* Le réseau ne peut fonctionner de façon stable et sûre qu’avec un socle minimum de moyens pilotables couplés, que l’on peut estimer à au moins 25 GW de puissance installée couplée (voir § 2). Il suffit en effet que ces moyens soient couplés pour apporter leur inertie, indépendamment de la puissance qu’ils produisent. Or, parmi les moyens décarbonés présents, on trouvera les moyens hydrauliques au fil de l’eau, les moyens utilisant la biomasse fatale (déchets) mais surtout le parc nucléaire, seul capable de modulations de puissance de très grandes amplitudes, les moyens thermiques au gaz, l’hydraulique de barrages et les STEPs, étant capables de modulations plus rapides mais de bien moindres amplitudes. La puissance réelle fournie par ces moyens pourra certes être un peu inférieure à 25 GW, mais elle viendra dans tous les cas réduire les possibilités d’absorption des productions photovoltaïques.

* Au total, il y aura de façon certaine trop d’électricité photovoltaïque aux heures les plus ensoleillées et ces surplus devront impérativement être écrêtés pour ne pas déstabiliser la fréquence et la tension du réseau. La production photovoltaïque devra se « cannibaliser » ...

* Cependant, à la descente du soleil, en l’espace d’environ 8 heures entre le midi solaire et la tombée de la nuit, le réseau devra absorber un transitoire de puissance d’une très grande amplitude, qui dépendra du niveau d’écrêtement du photovoltaïque, mais sera en tout état de cause de plusieurs dizaines de GW. Seul le nucléaire sera en mesure de compenser ce transitoire en augmentant progressivement sa puissance jusqu’à assurer la puissance nécessaire au passage de la soirée et de la nuit. Et le lendemain matin, il devra à nouveau réduire sa puissance pour laisser la place à la montée progressive de la puissance photovoltaïque. Et si le beau temps dure, le nucléaire devra moduler sa puissance de la sorte une fois par jour, tous les jours, en plus d’apporter de l’inertie au réseau.

Ce double rôle indispensable du nucléaire impliquera logiquement un fonctionnement en modulation profonde de puissance d’un certain nombre de réacteurs, sans arrêts y compris durant les week-ends, et dont les modalités seront fonction de plusieurs paramètres (niveau d’écrêtement du photovoltaïque, besoins en puissance du réseau, etc.). La même problématique se posera face aux productions éoliennes et/ou aux productions combinées photovoltaïques + éoliennes, qui ne sont en général pas maximales en même temps mais dont les cumuls peuvent excéder la production photovoltaïque maximale. Ces situations sont beaucoup plus difficiles à analyser du fait des variations nettement plus erratiques et parfois plus rapides de la production éolienne. Leur analyse ne peut se faire qu’à partir de nombreuses statistiques au pas horaire.

Dans tous les cas, le nucléaire sera appelé à compenser de plus en plus de variations de puissance éolienne et/ou photovoltaïque d’amplitudes croissantes et à stabiliser le réseau par son apport d’inertie, tandis que l’éolien et/ou le photovoltaïque devront de leur côté être profondément écrêtés à certaines périodes. Cependant, cette compensation par le nucléaire aura des limites techniques, économiques ou capacitaires qui s’imposeront. En particulier, la flexibilité accrue du nucléaire ne devra en aucun cas être préjudiciable à la prolongation des réacteurs au-delà de 60 ans, condition d’importance stratégique pour disposer de suffisamment d’électricité nucléaire en 2050 (voir plus loin § 4).

NB : Cette situation aura en conséquence un impact économique majeur sur les fondamentaux du système électrique : le nucléaire devra enfin être rémunéré d’une façon ou d’une autre pour les services qu’il rendra (ce qui n’est pas suffisamment le cas actuellement via le marché de capacités) et la rémunération de l’éolien et du photovoltaïque devra être profondément adaptée. Cela aura aussi un impact majeur sur les règles actuelles de fonctionnement du marché de l’électricité qui devront être largement revues, ce qui ne sera pas une mince affaire dans le contexte européen, d’autant plus qu’elles auront en outre un impact potentiel sur les choix des investissements à venir.

Il s’agit donc là d’un chantier très difficile et long à mener, qui doit en conséquence être correctement anticipé, ce qui ne semble pas être le cas actuellement. Pourtant, les difficultés vont aller crescendo d’ici 2030, c’est-à-dire demain à l’échelle du système électrique français et européen.

- En Allemagne

La même problématique va se poser, mais à une échelle bien supérieure, pour plusieurs raisons : elle a très peu d’hydraulique et ne dispose pas de nucléaire pour équilibrer son réseau et elle prévoit des capacités installées en éolien et photovoltaïque très supérieures, selon les prévisions allemandes officielles (loi EEG 2023 – Source : réf. [11]) résumées dans le tableau 1 ci-dessous (puissances installées en GW) :

(*) Moyens de secours thermiques (CCG et TAC) fonctionnant à l’hydrogène décarboné, partiellement en 2035 et totalement en 2045, l’Allemagne ayant annoncé une production totalement décarbonée à cette dernière date. Les dimensionnements de ces moyens devront permettre d’une part de « former » le réseau en permanence, d’autre part d’assurer l’équilibre production-consommation en puissance et en énergie en toutes circonstances (voir ci-dessous).

Plusieurs cas de fonctionnements critiques doivent être analysés pour un mix de ce type :

* Lors d’une journée d’été très ensoleillée en 2045, les 400 GW installés de photovoltaïque pourront produire jusqu’à plus 350 GW lorsque le soleil sera au zénith, alors que la consommation ne dépassera probablement pas une centaine de GW. Les surplus pourront donc atteindre 250 GW dont seule une partie pourra être absorbée par : les électrolyseurs fabricant de l’hydrogène décarboné ; la recharge des STEPs et celle des véhicules électriques ; d’éventuelles exportations. Mais ces dernières seront limitées d’une part par les capacités des lignes d’interconnexion avec les pays voisins et d’autre part et surtout par le fait que ces derniers auront de fortes chances d’être eux aussi également ensoleillés et de disposer également de surplus de productions photovoltaïques au même moment.

La seule solution pour ne pas détruire l’équilibre du réseau européen (pas seulement celui du réseau allemand) sera alors un écrêtement considérable de la production photovoltaïque (probablement entre une et deux centaines de GW). Et si ce n’est pas fait par l’Allemagne, il n’y aura pas d’autre solution qu’un blocage temporaire des interconnexions avec ce pays via des transformateurs-déphaseurs pour protéger l’équilibre de notre propre réseau, ce que feront également d’autres pays par nécessité, mesure ultime actuellement contraire aux règles d’échanges entre pays, mais qui devront évoluer si nécessaire.

Mais ce n’est pas tout : la descente du soleil entre l’heure méridienne et la tombée de la nuit jusqu’à une puissance nulle entraînera un transitoire de puissance d’une amplitude extrêmement importante très difficile à maîtriser, car il ne restera plus ensuite que l’hydraulique et la biomasse pilotables (≈ 21 GW seulement) et l’éolien, incertain et non pilotable. Or, en été, des cas d’anticyclones avec épisodes de vents très faibles ne sont pas rares, qui aggraveront la situation. Il est possible d’en évaluer les impacts possibles.

Selon RTE, la puissance éolienne tombe au-dessous de 10 % pendant environ 10 % des heures annuelles, réparties sur l’année. Quant aux GRT allemands, homologues de RTE, ils tablent dans leurs études de sécurité d’alimentation sur un minimum de puissance éolienne de 1 % à terre et de 4 % en mer. La combinaison des deux permet donc de conclure que la puissance éolienne se situe statistiquement entre environ 1 % et 10 % pendant 10 % du temps, toutes saisons confondues.

Appliqué aux 160 + 70 = 230 GW d’éolien allemand en 2045, cela donne donc une production éolienne comprise entre environ... 4,4 GW et 23 GW pendant les épisodes de vents faibles, en dépit de la considérable puissance installée. La puissance totale du mix renouvelable allemand durant ces périodes se situera alors entre 21 + 4,4 ≈ 25 GW et 21 + 23 = 44 GW, puissances bien insuffisantes pour alimenter le pays, malgré les recours aux déstockages des STEPs et des batteries, dont les capacités seront épuisées en quelques heures, et aux effacements et/ou reports de consommation, d’amplitudes bien insuffisantes.

Il en résulte que ce mix renouvelable allemand ne pourra absolument pas fonctionner sans un recours très important à des moyens pilotables thermiques fonctionnant à l’hydrogène (CCG et TAC), y compris durant l’été, période durant laquelle la consommation est pourtant la plus basse. Plusieurs dizaines de GW de ces moyens pilotables devront être activés lors des soirées et nuits d’été, en fonction du niveau de consommation et de la puissance éolienne disponible.

* À l’opposé, les journées hivernales très froides poseront beaucoup moins la question des surplus photovoltaïques diurnes, ces productions étant à 4 à 5 fois plus faibles, mais renforceront la criticité du passage des longues soirées et nuits froides par vents faibles. En effet, les pointes de consommation en Allemagne sont estimées à 120 GW en 2030/2035 par les GRT allemands et pourraient atteindre plus de 150 GW en 2045 selon l’institut allemand Fraunhofer (réf.[12]).

Comme le mix renouvelable allemand à cette date ne fournirait que 25 à 44 GW de puissance lors des nuits par vents faibles (voir ci-dessus), le déficit en puissance se situerait entre ≈ 116 et ≈ 125 GW dans les cas les plus critiques, et les effacements et/ou reports de consommations apporteraient au mieux une à deux dizaines de GW. En outre, des marges de sécurité devraient être ajoutées aux besoins.

L’institut Fraunhofer prévoit donc un besoin d’environ ≈ 63 GW de CCG et ≈ 88 GW de TAC fonctionnant au gaz à l’horizon 2045 pour sécuriser le réseau. Cependant, dans la logique de décarbonation de son secteur électrique annoncée par l’Allemagne à cette date, ces moyens devraient passer à l’hydrogène décarboné. Mais comme elle ne pourra pas en produire suffisamment sur son territoire, l’Allemagne mise sur des importations massives d’hydrogène décarboné : jusqu’à 15,5 Mt d’hydrogène en 2050 selon (réf.[5]), représentant une énergie d’environ 517 TWh.

4 – Comparaison de deux mix que tout oppose : « 100 % renouvelable » versus « nucléaire majoritaire »

Cette comparaison est faite sur la base d’une production annuelle totale de 950 TWh d’électricité, qui correspond grosso modo aux prévisions de l’Allemagne pour 2045 et à une estimation non officielle mais réaliste des besoins de la France pour 2050.

Elle s’appuie donc sur des hypothèses et des ordres de grandeur vraisemblables aux horizons considérés.

- Dimensionnements des mix nécessaires

- Mix « 100 % renouvelable » allemand

On se placera ici dans l’hypothèse d’un mix dont le fonctionnement est techniquement connu et certain (§ 3, hypothèse 2, p. 12). Si l’on reprend les hypothèses de l’étude EDF R&D avec 40 % de production variable et intermittente et 60 % de production pilotable, on arrive aux valeurs annuelles suivantes :

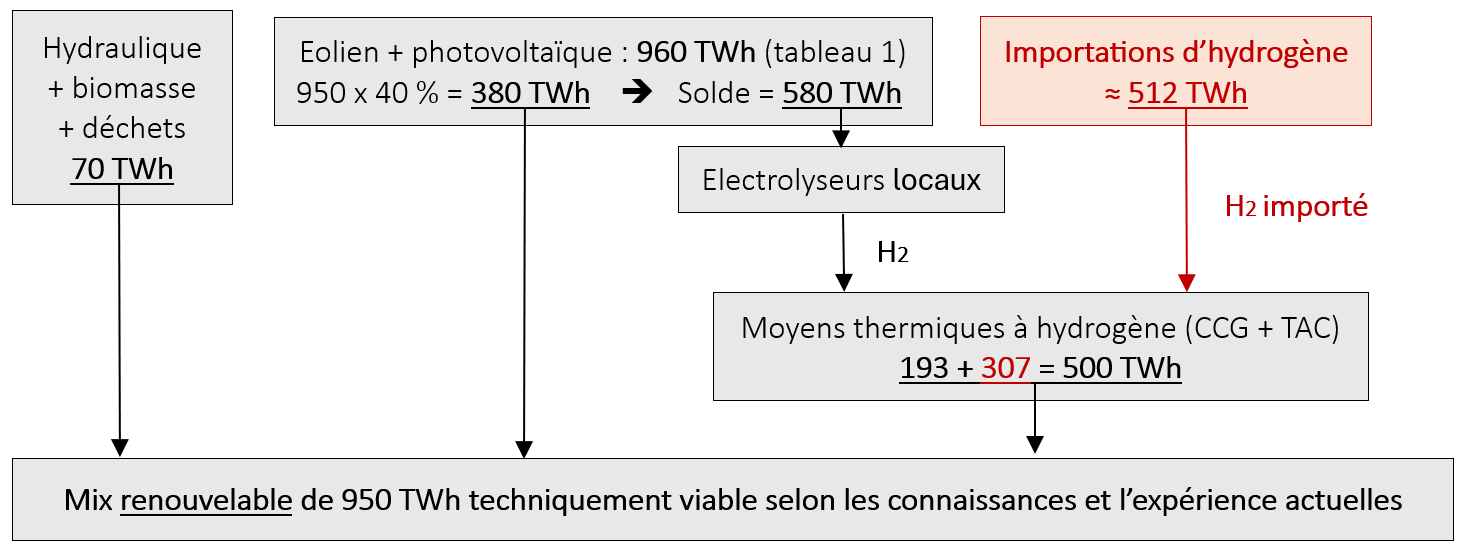

* Production éolienne et/ou photovoltaïque directement consommée : 950 x 0,40 = 380 TWh

* Production pilotable nécessaire : 950 x 0,60 = 570 TWh, dont 70 (voir tableau 1) sont apportés par l’hydraulique, la biomasse et les déchets. Le reste, soit 500 TWh, doit être produit par des moyens thermiques fonctionnant à l’hydrogène, ce dernier provenant d’une part du solde des productions éoliennes et/ou photovoltaïques, d’autre part par des importations d’hydrogène. Au total, la production de ce mix est schématisée par la figure 3 ci-dessous :

Ce schéma met en évidence l’enjeu des besoins colossaux en hydrogène :

* Les 580 TWh d’électricité éolienne et/ou photovoltaïque utilisés pour sa production impliquent de disposer d’un parc d’électrolyseurs extrêmement important, dont la production dépendra de leur facteur de charge moyen. Si l’on retient ≈ 50 % du fait du caractère variable et intermittent de ces sources d’électricité, au moins 130 GW installés d’électrolyseurs sont nécessaires ;

* Mais comme il n’y aura pas suffisamment d’électricité éolienne et/ou photovoltaïque pour produire la totalité de l’hydrogène nécessaire au fonctionnement des moyens thermiques du fait d’un rendement d’environ 33 % de la chaîne de conversion globale, le recours à de l’hydrogène importé en complément sera indispensable. Il sera brûlé avec un rendement d’environ 60 % dans un CCG performant ;

En résumé, selon ce schéma, pour disposer de 950 TWh d’électricité « 100 % renouvelable », garantir l’équilibre et la sécurité d’alimentation de son réseau et décarboner son mix électrique, l’Allemagne devrait disposer d’un parc considérable de 630 GW installés de moyens éoliens et photovoltaïques et importer en outre 500 TWh d’hydrogène.

Et comme déjà indiqué plus haut, elle devrait en outre disposer, selon l’Institut Fraunhofer, d’un parc d’environ 63 GW de CCG et 88 GW de TAC fonctionnant à l’hydrogène pour faire face en toutes circonstances à la stabilité du réseau et aux manques de production de l’éolien et/ou du photovoltaïque.

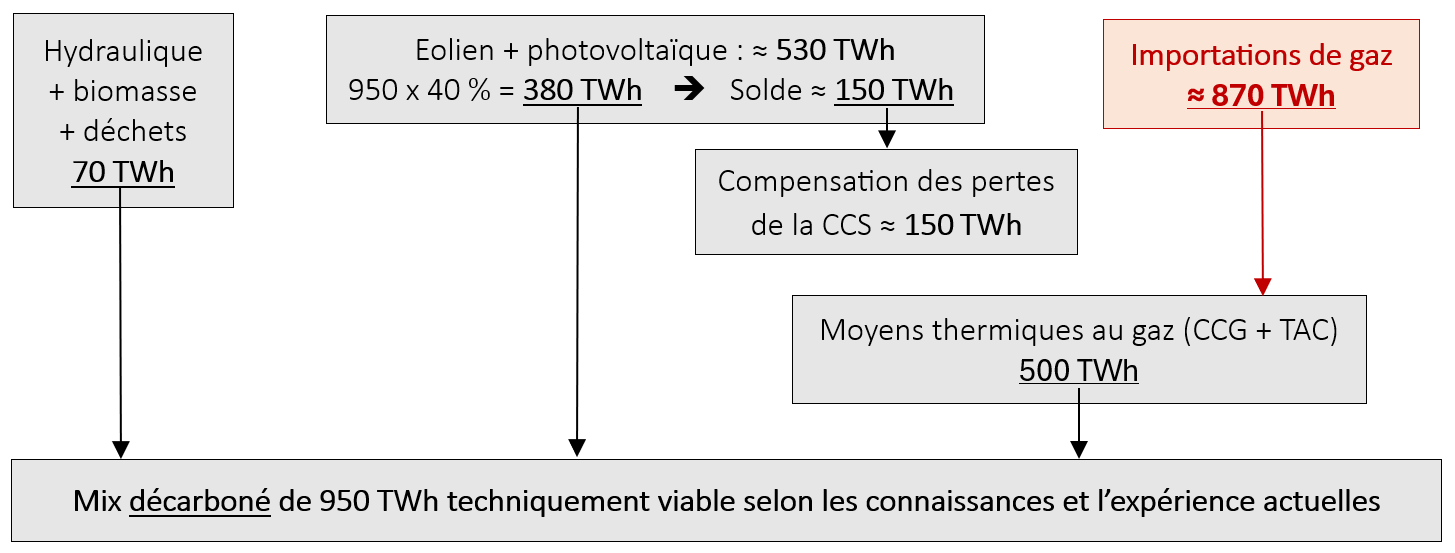

Cependant, en cas d’échec pour une raison ou une autre de cette stratégie « 100 % renouvelable » + importations massives d’hydrogène], l’Allemagne n’aurait d’autre solution que de faire fonctionner ses CCG et TAC précités avec du gaz fossile et de recourir à la capture et à la séquestration du carbone (CCS) selon le schéma de la figure 4 ci-dessous. Cette dernière met en évidence que les importations nécessaires de gaz s’élèveraient à environ 870 TWh et que les productions éoliennes et photovoltaïques pourraient être réduites à environ 530 TWh, comprenant l’énergie nécessaire pour faire fonctionner la CCS (≈ 30 % de 500 TWh soit 150 TWh). Mais cette solution n’est ni durable à long terme, ni « 100 % renouvelable », et impliquerait pour être décarbonée que la CCS absorbe la totalité du CO2 émis, soit plus de 200 Mt/an, quantité considérable. Ceci sans préjudice des incertitudes et difficultés de mise en œuvre de cette technologie soulignées au §3 (hypothèse 3, page 12).

- Mix « nucléaire majoritaire » français

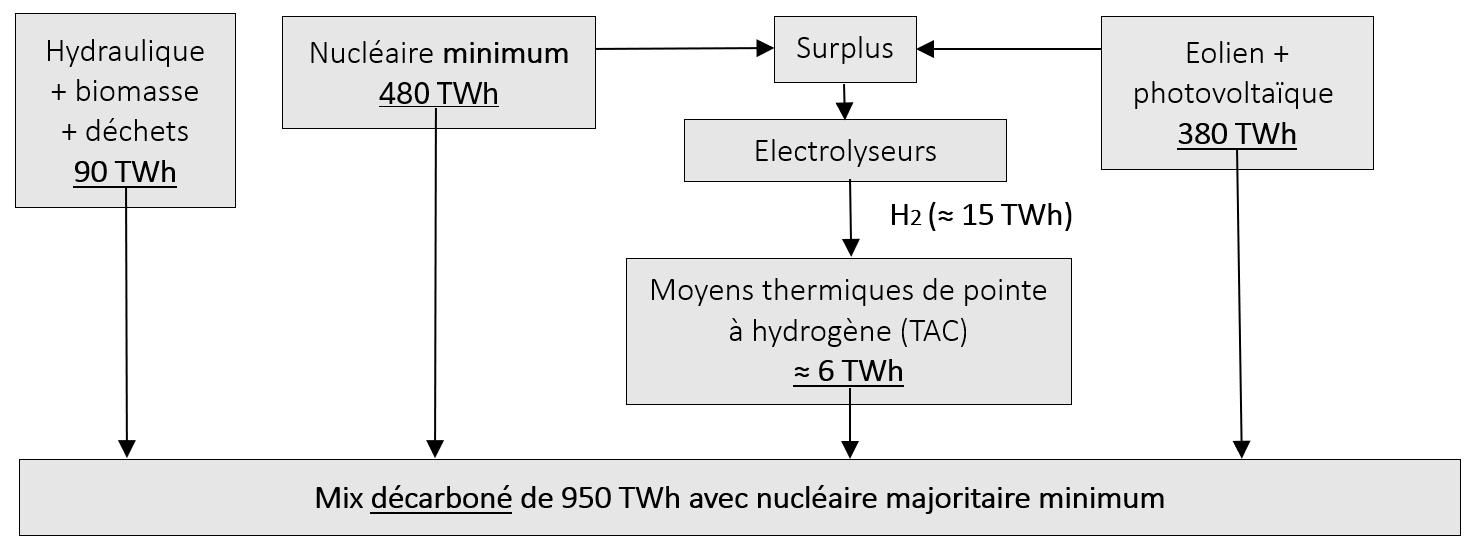

Majoritaire signifie ici qu’au moins 50 % de la production totale est réalisée à partir de nucléaire. En restant prudent sur les possibilités de productions hydrauliques ou à partir de biomasse en 2050, dont les extensions sont limitées dans les deux cas, on retiendra les valeurs annuelles suivantes : environ 75 TWh d’hydraulique et 15 TWh de biomasse et déchets, soit un total de ≈ 90 TWh.

Toujours dans la logique de l’étude EDF R&D, pour limiter à 40 % la production éolienne et/ou photovoltaïque, soit 380 TWh, le nucléaire devra donc produire au minimum : 950 – 90 – 380 = 480 TWh.

La production de ce mix est schématisée sur la figure 5 ci-dessous. On notera que conformément aux projections officielles, aucune importation d’hydrogène n’est envisagée, le mix considéré étant apte à fournir les besoins en hydrogène et ses dérivés pour le reste de l’économie (hors besoins de stockage d’énergie pour les besoins du réseau, très faibles).

Pour produire 480 TWh d’électricité nucléaire avec quelques marges, il faut disposer d’au moins 76 GW installés, soit environ 20 % de plus qu’actuellement. Ce mix n’est cependant pas très satisfaisant pour au moins deux raisons :

* Il nécessite une production éolienne et/ou photovoltaïque très importante de 380 TWh, environ 50 % plus élevée que celle prévue par la PPE (de l’ordre de ≈ 250 TWh, voir plus haut, § 3, p.14) dont les amplitudes de variations en puissance soulèvent déjà des difficultés majeures de compensation ;

* Sa puissance maximale possible ne permet pas de passer les pointes les plus élevées, si on les estime également à ≈ 150 GW. En effet, l’hydraulique (STEPs comprises) avec ≈ 18 GW de puissance historique maximale et la biomasse avec ≈ 2 GW ne dépassent pas actuellement ≈ 20 GW, qui pourraient sans doute être raisonnablement augmentés d’environ 20 % d’ici 2050, pour atteindre ≈ 24 GW. Ajoutés aux 76 GW de nucléaire avec une disponibilité maximale supposée de 96 % lors des pointes hivernales de consommation, cela permettrait de produire ≈ 73 GW, pour un total de 97 GW de production pilotable.

En supposant que les effacements et/ou les reports permettent de réduire la consommation à la pointe d’environ 16 GW (≈ 10 pour l’industrie et ≈ 6 pour les bâtiments domestiques et tertiaires selon RTE) le déficit serait alors de l’ordre de de 150 – 97 – 16 ≈ 37 GW lors des nuits d’hiver sans vent. Si on y ajoute une marge, le besoin approcherait les 40 GW.

Dans un système décarboné, cette puissance de pointe devrait logiquement être apportée par des TAC fonctionnant à l’hydrogène dont les durées de fonctionnement ne devraient pas dépasser une à deux centaines d’heures par an, à l’instar des TAC actuelles. Le besoin en hydrogène décarboné devrait donc être très faible, de l’ordre de ≈ 15 TWh par an, mais il ne sera pas nul.

Il résulte des deux raisons ci-dessus qu’il est hautement souhaitable d’aller significativement au-delà de 50 % de production nucléaire, sachant que cela implique un double défi industriel :

* Prolonger la quasi-totalité du parc actuel jusqu’à 70 à 80 ans pour disposer d’une capacité nucléaire importante en 2050 en évitant une baisse de capacité très importante en 2050. C’est un enjeu d’intérêt stratégique. En effet, 15 GW du parc actuel atteindront 60 ans d’ici 2042 et 30 GW d’ici 2045. Prolonger le parc de 10 à 20 ans supplémentaires au-delà de 60 ans permettrait de le conserver intégralement en 2050 et un peu au-delà, pour laisser au nouveau nucléaire davantage de temps pour monter en capacité ;

* Construire suffisamment de nouveaux moyens d’ici 2050. Les perspectives actuellement avancées tablent sur 14 réacteurs EPR2 (≈ 23 GW) mis en service entre 2037 et 2050, soit en moyenne ≈ 1 EPR2 par an sur la période. Aller au-delà de ce rythme n’est probablement envisageable qu’à partir de 2040 et reste un défi majeur vu d’aujourd’hui qui doit être préparé dès maintenant.

Au total, il apparaît qu’il ne sera pas facile d’aller bien au-delà d’une cible de 63 + 23 = 86 GW dès 2050, pour une production annuelle d’environ 545 TWh et un taux de pénétration d’environ 57 %, qui réduirait la production éolienne et/ou photovoltaïque à 315 TWh, et ramènerait son taux de pénétration à environ 33 %.

Il s’ensuit également que la construction de nouveaux moyens nucléaires devra être prolongée bien au-delà de 2050, d’autant plus qu’il faudra alors faire face au déclassement très rapide du parc actuel. Construire de nouveaux réacteurs nucléaires EPR2 et ensuite ses successeurs RNR constitue donc un projet industriel de très grande ampleur et de très longue durée, qui se prolongera largement dans la deuxième moitié de ce siècle.

NB : une autre raison pousse à limiter le taux d’intégration d’éolien et/ou de photovoltaïque : le surcoût de compensation de leur variabilité et intermittence. Selon l’AEN (réf.[13]) ces surcoûts sont de l’ordre de moins de 10 €/MWh pour une intégration de 10 %, d’un peu plus de 20 €/MWh pour 30 % et croissent ensuite très fortement. Ceci sans tenir compte des coûts des réseaux qui explosent avec la multiplication des raccordements éoliens et photovoltaïques.

- Estimation approximative des coûts de production de l’électricité

Il est possible de se faire une première idée très approximative du coût des MWh de ces mix, sur la base des coûts moyens de production unitaires des différents moyens mis en œuvre. On retiendra pour ce faire les hypothèses simplifiées suivantes, sachant qu’il s’agit de coûts et non de prix de vente :

* Hydraulique, biomasse solide et déchets : ≈ 60 €/MWh

* Eolien et photovoltaïque, toutes tailles d’installations confondues : ≈ 70 €/MWh

* Moyens thermiques fonctionnant à l’hydrogène décarboné : dans son étude futurs énergétiques 2050, RTE évalue leurs coûts de production à environ 240 €/MWh pour un CCG et 350 €/MWh pour une TAC de pointe, sur la base d’un coût de cet hydrogène estimé à environ 4 €/kg.

NB : ce coût de l’hydrogène est une estimation basse pour de l’hydrogène décarboné produit par électrolyse. C’est encore plus vrai pour de l’hydrogène importé, qui sera peut-être produit à un coût un peu inférieur dans les pays fortement ensoleillés, mais dont le coût à l’arrivée sera plombé par les coûts de transport et de stockage, pour lesquels on manque de références fiables à l’heure actuelle, mais qui seront de façon certaine élevés compte tenu des très grandes difficultés de transport de ce gaz.

* Nucléaire : ≈ 50 €/MWh pour le nucléaire actuel et ≈ 85 €/MWh pour le nouveau nucléaire (EPR2). Compte tenu de la pondération des capacités respectives de l’ordre de (63-23) qui pourrait exister en 2050, la moyenne pondérée s’établit à :

(50 x 63 + 85 x 23)/86 ≈ 60 €/MWh

Sur la base de ces coûts unitaires, il est alors possible d’estimer les coûts moyens pondérés des mix considérés.

- Mix « 100 % renouvelable » allemand

Cette estimation est faite dans le seul cas où des estimations de coûts sont connues, à savoir celui du mix de la figure 3 utilisant l’hydrogène. Par ailleurs, les TAC ne fonctionnant que très peu dans l’année, on retiendra pour simplifier le seul coût des CCG.

On aboutit alors à un coût moyen pondéré du mix de l’ordre de :

(60 x 70 + 70 x 380 + 240 x 500)/950 ≈ 160 €/MWh

C’est un coût moyen de production très élevé, pourtant fondé sur une estimation basse du prix de l’hydrogène décarboné dont l’atteinte est loin d’être acquise et auquel il faut ajouter les coûts des externalités, notamment les surcoûts des réseaux, bien supérieur à celui d’un système majoritairement nucléaire. Il faut en effet raccorder 630 GW d’éolien et/ou photovoltaïque, 130 GW d’électrolyseurs et 150 GW de moyens thermiques fonctionnant à l’hydrogène, soit un total de plus de 900 GW de moyens à raccorder au réseau.

- Mix « nucléaire majoritaire » français

On aboutit dans ce cas à un coût moyen pondéré du mix de l’ordre de :

(60 x 90 + 70 x 380 + 60 x 480)/950 ≈ 64 €/MWh

Ce coût, inférieur d’environ 60 % à celui du mix allemand, est en outre associé à des coûts d’externalités très inférieurs. Pour le seul réseau, dans l’hypothèse d’un maximum de 33 % d’intégration d’électricité éolienne et/ou photovoltaïque, seuls 313 GW environ seraient à raccorder, auxquels il faudrait ajouter 23 GW de nouveau nucléaire, soit un total de moins de 340 GW. Là encore, c’est environ 60 % en moins.

5 – Synthèse et conclusions

Pour répondre à la question posée dans le titre de la présente note, l’étude d’EDF R&D de juin 2015 a servi de base pour plusieurs raisons :

* C’est d’abord une étude de référence de grande qualité, largement reconnue y compris aux Etats-Unis où ses auteurs ont obtenu un « Award » (Prix honorifique) de l’UVIG (The Utility Variable-Generation Integration Group) américain.

* Cette étude aboutit à un critère global simple à utiliser, qui intègre implicitement les contraintes physiques de « formation » d’un réseau et d’inertie mécanique nécessaires à sa stabilité, et qui permet de conclure qu’il est possible d’intégrer jusqu’à 40 % d’électricité variable et intermittente en puissance moyenne annuelle sur la plaque synchrone continentale européenne (c’est ce niveau géographique qui est pertinent, les pays européens étant fortement interconnectés et constituant un seul réseau). Ceci sous certaines conditions additionnelles limitées qui ne modifient pas la nature du système électrique, qui, point capital, reste dans tous les cas « formé » par des machines synchrones.

* Or, le taux réel actuel d’intégration d’électricité variable et intermittente sur la plaque européenne est à ce jour d’environ 30 % en moyenne en moyenne annuelle. Cela signifie que dans son ensemble, la plaque européenne reste toujours « formée » par les machines synchrones, même si certains pays dépassent le taux de 40 % et si leurs réseaux sont de ce fait de plus en plus perturbés par la montée en puissance de l’éolien et du photovoltaïque. L’Europe continentale n’a donc pas encore atteint la limite de 40 % et le plus difficile reste à venir... (Le « petit » réseau de l’île irlandaise, relativement isolé du réseau du Royaume-Uni et qui fait pour cela figure de « laboratoire avancé » pour l’Europe est à peu près parvenu à ce taux de 40 %, mais dans les conditions particulières explicitées plus haut, non généralisables aux grands réseaux européens).

* En dépit du fait que le critère de 40 % maximum d’électricité variable et intermittente conduise très probablement à surestimer les besoins nécessaires en moyens pilotables pour stabiliser le réseau, l’examen de la viabilité physique et économique d’un système de type « 100 % renouvelable » laisse peu de doutes sur l’impasse énergétique et environnementale que constitue cette option.

En effet : faire fonctionner des réseaux sans suffisamment de machines synchrones est aujourd’hui un PARI extrêmement dangereux s’agissant d’installations d’importance vitale pour un pays moderne ; miser sur les quantités d’hydrogène décarboné extrêmement importantes qui devraient être produites à partir d’électricité éolienne et/ou photovoltaïque pour faire fonctionner les indispensables moyens pilotables se heurte à des pertes énergétiques colossales. Quant aux importations à grande échelle d’hydrogène décarboné, sujet à la mode actuellement, elles conduisent également à une nouvelle dépendance géopolitique, certes différente de celle du gaz, mais également dangereuse en cas de conflit mondial ; enfin, utiliser le gaz fossile associé à la capture et la séquestration du carbone (CCS) à la très grande échelle qui serait nécessaire est extrêmement hasardeux en l’état actuel de cette technologie et pérenniserait par ailleurs la dépendance aux fournisseurs de gaz fossile, qui ne sera pas non plus éternel... Et pourrait, en cas d’échec industriel ou économique, se terminer par une absence de décarbonation catastrophique pour le climat.

Des études approfondies réalisées au pas horaire et tenant compte de toutes les flexibilités évoquées plus haut permettraient sans doute de réduire différentes contraintes, mais gagner 10, 20 voire 30 % sur les besoins en puissance pilotable nécessaire pour garantir le fonctionnement du réseau et assurer la décarbonation du mix ne changerait pas fondamentalement la donne, tant les ordres de grandeur sont importants.